Ex responsable de seguridad de OpenAI alerta sobre la reintroducción de contenido erótico

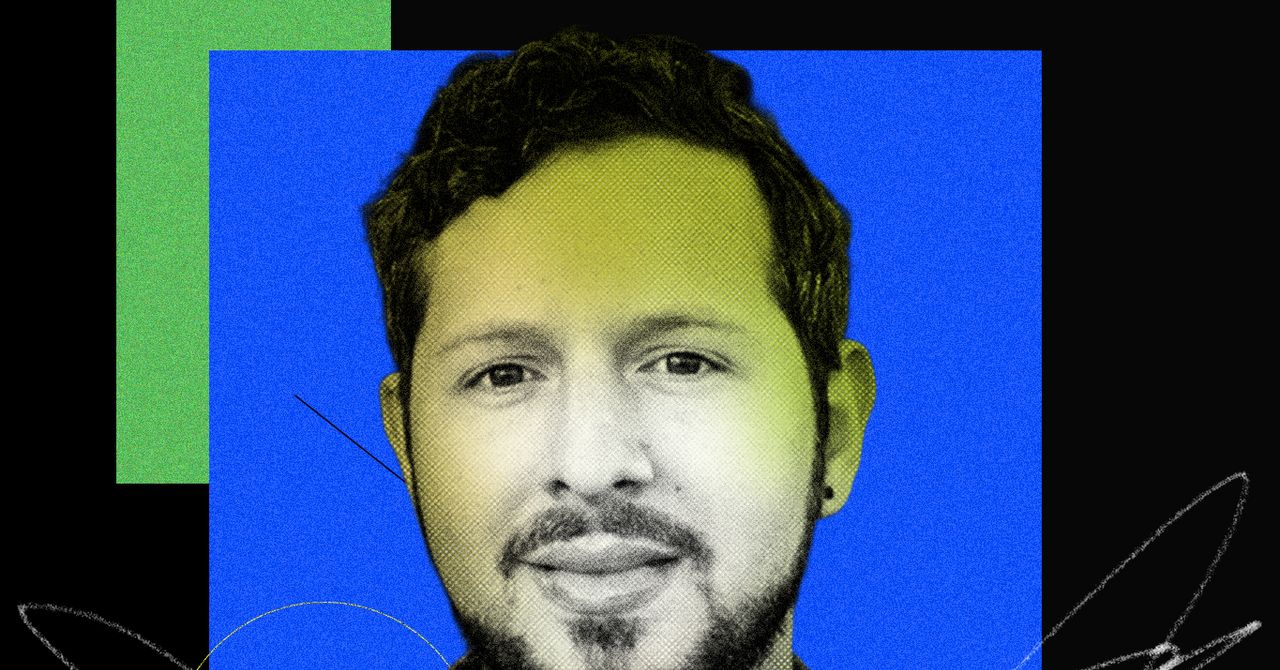

Antecedentes

Steven Adler pasó varios años liderando iniciativas de seguridad en OpenAI, donde ayudó a dar forma a políticas para modelos de lenguaje grande y sistemas avanzados. Su rol involucró evaluar riesgos de productos, evaluar capacidades peligrosas y asesorar sobre la preparación de AI cada vez más capaz.

Erosión de las medidas de seguridad

Adler explicó que la empresa previamente bloqueó el contenido erótico después de descubrir un aumento de tráfico de roleo sexual que surgió involuntariamente de las interacciones de los usuarios. Dijo que la decisión se basó en herramientas limitadas para monitorear y mitigar dichos casos de uso, y en preocupaciones sobre el impacto en la salud mental de los usuarios.

Reintroducción de contenido erótico

El anuncio reciente de OpenAI de levantar la restricción para adultos verificados, según Adler, se basa en afirmaciones de nuevas herramientas de mitigación. Advirtió que la evidencia de estas herramientas remains opaca y que los usuarios merecen más que aseguranzas verbales. Instó a la empresa a demostrar salvaguardias concretas antes de expandir el acceso.

Riesgos para la salud mental

Adler destacó las preocupaciones continuas sobre una porción significativa de usuarios que muestra señales de angustia mental severa al interactuar con el chatbot. Argumentó que sin datos longitudinales transparentes que muestren una disminución de dichos incidentes, es difícil evaluar si las nuevas medidas son efectivas.

Llamado a la transparencia y la rendición de cuentas

El ex jefe de seguridad llamó a la publicación regular de métricas de seguridad, similar a las prácticas de otras plataformas grandes. Sugirió que OpenAI debería compartir datos comparativos sobre el tiempo para construir confianza y permitir la escrutinio externo.

Estándares de seguridad a nivel de industria

Adler señaló la falta de estándares de seguridad uniformes en los desarrolladores de AI y abogó por regímenes de pruebas estandarizadas, comparándolos con las inspecciones de seguridad de vehículos. Señaló los marcos regulatorios emergentes en Europa como un paso hacia un modelado de riesgos más riguroso.

Perspectiva futura

Mirando hacia adelante, Adler enfatizó la importancia de desarrollar herramientas de interpretación que puedan identificar comportamientos internos del modelo y guiar despliegues más seguros. Advirtió que sin un esfuerzo coordinado de la industria, las presiones competitivas podrían superar las inversiones en seguridad, lo que podría llevar a resultados perjudiciales.

Usado: News Factory APP - descubrimiento de noticias y automatización - ChatGPT para Empresas