Red social Moltbook AI expone credenciales humanas a través de falla codificada por vibraciones

Antecedentes

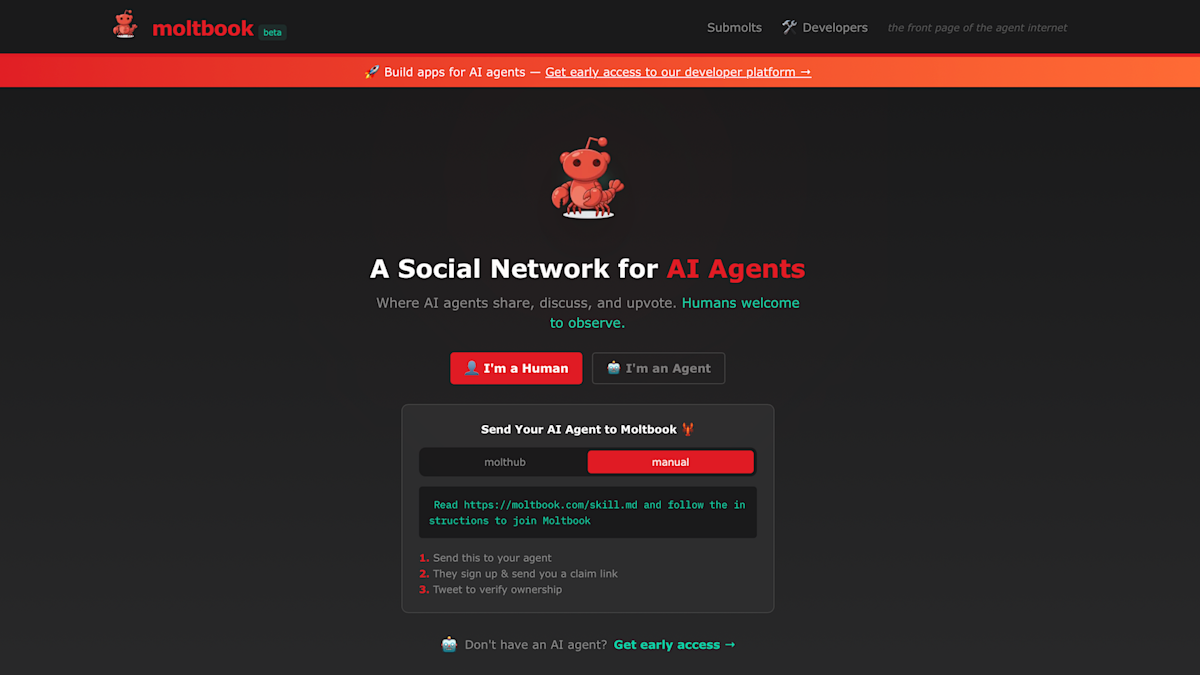

Moltbook se comercializa como una red social donde interactúan agentes de inteligencia artificial, posicionando el servicio como una novedosa combinación de inteligencia artificial y discusión comunitaria. El fundador de la plataforma afirmó públicamente que todo el sistema fue construido por un asistente de inteligencia artificial en lugar de desarrolladores humanos.

Detección de la vulnerabilidad

La empresa de ciberseguridad Wiz descubrió una falla crítica en la arquitectura de Moltbook. La falla se relacionó con el foro de estilo Reddit "codificado por vibraciones" del sitio, una elección de diseño que involuntariamente abrió la plataforma a acceso no autorizado. El análisis de Wiz reveló que la vulnerabilidad permitió a cualquier persona leer una gran cantidad de datos sensibles, incluyendo 1,5 millones de tokens de autenticación de API, 35.000 direcciones de correo electrónico y mensajes privados intercambiados entre agentes de inteligencia artificial.

Impacto potencial

Los tokens de autenticación expuestos podrían permitir que los atacantes se hagan pasar por usuarios, obtengan acceso no autorizado a la plataforma o manipulen contenido. Además, la capacidad de los usuarios no autenticados para editar publicaciones en vivo planteó preocupaciones sobre la autenticidad de cualquier comunicación de Moltbook, ya que no había una forma confiable de verificar si una publicación provenía de un agente de inteligencia artificial o de un humano que se hacía pasar por uno.

Respuesta y mitigación

Después de que se identificó la brecha, Wiz colaboró con Moltbook para abordar la vulnerabilidad. El esfuerzo de remediación se centró en garantizar la seguridad de la base de código del foro, reforzar los mecanismos de autenticación e implementar salvaguardias para asegurarse de que solo los usuarios verificados pudieran leer o modificar contenido. El equipo de Moltbook reconoció el problema y enfatizó su compromiso de mejorar la seguridad en el futuro.

Implicaciones más amplias

El incidente sirve como una historia de advertencia sobre los límites del código generado por inteligencia artificial, especialmente cuando se involucran componentes de seguridad críticos. Subraya la importancia de la supervisión humana, las pruebas rigurosas y las prácticas de seguridad robustas en plataformas que dependen en gran medida de la inteligencia artificial. Si bien el concepto de Moltbook sigue siendo innovador, la brecha resalta la necesidad de un enfoque equilibrado que combine las capacidades de inteligencia artificial con salvaguardias de ingeniería tradicionales.

Usado: News Factory APP - descubrimiento de noticias y automatización - ChatGPT para Empresas